-

Which Manticore product(s) do you use

您使用哪款 Manticore 产品?

-

What do you like about the Manticore product(s) you use?

你觉得 Manticore 产品好用的地方是啥 哪些方面/功能满意?

-

What features or functionalities do you think are missing?

您觉得缺少了啥功能

-

Are there any specific improvements or changes you would like to see?

您最希望改进哪些功能

-

How would you rate your overall experience with Manticore product(s)?

您的整体使用体验怎么样? 打个分 最好写出依据

-

How did you find out about Manticore, if you remember?

您咋找到的 Manticore

我需要查询 map 集合内某个 key 为某个值的数据。如果是把 map 集合转为 json 作为一个字段存到 ES 的应该可以解决,因为这种情况下我的字段名是固定的,我只需要将查询条件分词,然后根据字段名去和对应的 json 去匹配就可以了。

但是如果 map 的 key 是 index 的字段名应该如何搜索呢?

比如查询输入的是 手机品牌(字段名) 小米(值),但是 map 的 key 只有 品牌(字段名) 比如查询输入的是 价格(字段名) 21 (值),但是 map 的 key 只有 手机价格(字段名) 代码如下: 这段代码中 params 变量的 key 会作为字段名,value 会作为字段值

@Data @NoArgsConstructor @AllArgsConstructor @JsonIgnoreProperties(ignoreUnknown = true) @Document(indexName = "test_index") public class TopLevelParam implements Serializable { public static final String TECH_CODE="techCode"; public static final String PARAMS="params"; public static final String PARAMS_PREFIX="params."; @Id private String techCode; @Field(type = FieldType.Nested,dynamic = Dynamic.TRUE) private Map<String,Object> params =new HashMap<>(); } 这种情况怎么解决呢,open search 现在一直在迁移分片,但是始终不均衡 ]]>

问题: 执行 es 操作报错:Invalid or missing build flavor [ OSS ] ;发现是 es 和 springboot 版本不匹配;

行动: 在不考虑降低 springboot 版本前提和本地尝试搭建官网 7.5 的版本( 7.5.2 )做问题复现;客户 es 的 build_flavor 属性为 OSS ;我分别下载了 oss 版本和 default 版本;自测发现在 default 就不会有版本不一致导致得问题,只有 OSS 版本才会出现;了解了 OSS 和 default 的区别在于商业化,并且 default 包含 OSS 所有功能;

我的疑问:

1. 我指定了 es 连接的版本并且移除 springboot 默认的 es 版本还是无效,是我操作有问题还是什么

2. 为什么会提供 OSS 这种版本,大家生产环境是怎么选择的 ]]>

现在业务侧要求尽量实现:

-

1 、针对原纪录的全模糊查询,即只要输入的字符串是某个姓名的子序列,就将其捞出来; 例如,对于输入的 "张 aた" 是要匹配到 "张三 abきたない",因为不涉及到原字符的转换,这里直接使用了

1gram+match_phrase_prefix来实现了 -

2 、(目前遇到的问题) ,现在想要针对中简繁、日文、汉语等汉字系支持对应拼音、罗马音的模糊搜索, 例如,对于输入的 "张 san a ki t" 是要能够 匹配到 "张三 abきたない" 的; 即实际上要做到分词结果是 "张三 abきたない: 张 三 z h a n g s a n a b き た な い k i t a n a i" 的实现(当然这个我不是很确定是否是唯一解,只是认为如果能够达到这样的分词结果那就能满足我现在的搜索要求了)

我的问题是,如何实现这样的分词器呢?

- 如果使用 pinyin+1gram 分词器(即不考虑日语等),好像分词结果是 " 张 三 zhang san a b き た な い" ,而我输入的字符串因为无法确定是否中英文,所以默认是打散的,"张 san a ki t" 分词结果是 "张 s a n a k i t" ,从而无法匹配到

- 如果使用

icu_transform等,貌似没法保留原字符串(或者这种场景下的自定义分词器该如何实现呢)

先感谢 dalao 们回复

]]>- 根据一段文案(假设为商品标题)的向量值在 es 中查询出相似的文案(商品) knn_search

- 向量维度是 1024 维度 余弦函数计算距离

- 目前已有数据是 600w 左右 整体 es 数据量在 250g 左右

- es 节点 8c32g *3

问题

目前想前台使用这种向量查询的结果 但是问题是目前单次查询的效率很低基本上得 60s 左右才能返回。

- 有大佬有经验这种量级的查询大概需要升配到什么配置吗?

- 或者有什么其他的查询优化方案吗?

其他

- 为啥非得用 es 不用其他向量库 例如 milvus ?:因为存量数据在这儿,所以暂时没有迁移。

- 另外我看到的有限的返回结果中,很多文案相近但是不是同一个商品的也会被查询出来,准确率其实有待考证。

SaaS 项目,没有分库,ES 存储文章内容,并发不高没做分布式。ES 由前人设计,7.9 版本,一个索引存了所有数据,包括文章正文、标题、作者、摘要等等。正文采用 text 类型。整个索引用了 ik 分词并设置为 ik_max_word ,正文字段的搜索分词用 ik smart ,并设置了 fielddata 。

现在有租户提需求,希望通过关键词查询正文,并且要求结果里一定要出现完整的关键词。听上去很普通的需求?但是有问题啊啊,用 term 一直都会返回一些,不多,但完全没有搜索关键词的结果。

一开始以为是保留词的问题,所以把用户关心的几个关键词全加到保留词列表里( ik/config 下面,并配置好,重启,重建索引),但结果还是一样。也试过用 .keyword ,查询结果数量更少了。。

查了网上很多资料,看上去很简单的问题。有没有大佬给指个路?

感恩感恩。

]]>下载地址: https://github.com/Bronya0/ES-King , 支持 win 、mac 、linux 平台

多种配色可选,例如猛男粉:

后来想了一下这么做是不是复杂度有点太高了,现在 es 已经集成了大部分功能,自己开发服务的效果也不一定有保证,是不是直接用 es 自身来做就好了

想了解一下各位是怎么做的,es 集成的中文分词插件怎么样,以及需要重建索引怎么做比较好(这也是我想把分词外置的原因,可以提高一下重建速度)

]]>旧 elasticsearch 集群,几个节点都是全角色(主节点、数据节点),有数据。 现在新建了一个大集群,分开了节点角色,索引和数据为空。

能不能把旧集群的主节点功能禁用,只当数据节点,然后修改集群发现的配置,直接接到新集群里来。

这样问主要是不想折腾数据导入导出了。

]]>1. 用 GitHub 的 classic PAT(personal access token) 形式提供一个 URL 鉴权,形式: https://x-access-token:TOKEN@raw.githubusercontent.com/<user or organization>/<repo name>/<branch>/<path to file>/<file_name>

发现 cURL 还支持这种 URL ,但现代浏览器( Chrome 、Safari )都不再支持这种形式,elasticsearch-analysis-ik 也不支持。

这种方法最简单优雅,可惜没跑通。

2. Nginx 监听一个 localhost 下的端口,作为文件服务器。词库文件指向 Git 目录,该目录以固定频率去 pull 代码。

请问大家有更优雅的实现么?谢谢大家。 ]]>

简单来说需求是

根据名称查数据,返回每条数据的相似度(类似的得分吧) 相似度区间要求在 0-1 之间

实在没思路啦,求指导 ]]>

比如一个商品是 XL 汤锅,搜索锅是查询不到的

某个商品为 XX 护关节钙片,搜索护肝是可以搜索到的(运营的意思是应该搜索不到)

有大佬给支个招吗? ]]>

前言

ELK 的一大缺点就是这东西最初是没有登录机制的,只要拿到了 url 地址,kibana 看板谁都可以访问一下。后来 ELK 自带了一套 xpack 进行登录认证,可是除了账户名密码登录这种最原始的方法,剩下的高级功能,比如 oauth, oidc, ldap ,统统都是收费的.....总不能给每个人都专门搞一个 kibana 账户名密码吧......

所以呢,这里有一个基于 casdoor 的 elk 鉴权解决方案,不要钱,开源的,还有人维护呢~。Casdoor 是一个基于 OAuth 2.0 / OIDC 的 UI 优先集中认证 / 单点登录 (SSO) 平台,而 casdoor/elk-auth-casdoor 这套解决方案,则是一个反向代理,他可以拦截所有未经登录的前往 elk 的 http 访问流量,并且引导未登录用户进行登录,而且这个反向代理对已登录用户是完全透明的。

仓库地址 https://github.com/casdoor/elk-auth-casdoor

QQ 群:645200447

如果您有更多相关的特殊需求可以加群,我们会有专人对接~ (可以联系 ComradeProgrammer )

casdoor 是什么

Casdoor 是一个基于 OAuth 2.0 / OIDC 的 UI 优先集中认证 / 单点登录 (SSO) 平台,简单点说,就是 Casdoor 可以帮你解决 用户管理 的难题,你无需开发用户登录注册等与用户鉴权相关的一系列功能,只需几个步骤,简单配置,与你的主应用配合,便可完全托管你的用户模块,简单省心,功能强大。

仓库地址: https://github.com/casbin/casdoor

演示地址: https://door.casbin.com/

官网文档: https://casdoor.org/

QQ 群:645200447

Casdoor 还支持 ldap ,saml 等诸多功能.....

Casdoor 目前作为 Casbin 社区项目统一使用的鉴权平台,项目已开源,希望得到大家的一些建议和 Star~,我们会及时跟进反馈并改正问题哒

Casdoor 又有哪些特性?

- 支持普通的账户密码注册登录,也支持各种常见的第三方认证,例如 GitHub 、Facebook 、Google 、Wechat 、QQ 、LinkedIn 等等,截止目前共 9 个平台,并在不断听取用户建议对更多的平台提供支持。

- 管理方便。Casdoor 内部将模块分为了 5 大类,Organization 、User 、Application 、Token 和 Provider 。可以同时接入多个组织,组织下有不同应用,用户可以通过应用或组织分类,单独管理任何组织、应用或用户的 Token 令牌,轻松管理复杂系统,目前已部署在 Casbin 社区各种系统当作鉴权平台。

- 自定义程度高。Casdoor 可以随意修改登录方式,例如是否允许密码或第三方登录,自定义应用的注册项数量,是否启用两步验证,以及是否允许各个 Provider 登录、注册等等,高度可插拔。

- 具备 Swagger API 文档。清晰的 API 介绍,无需阅读源代码即可直接方便调用各个 API 接口,提供定制化功能。

- 前后端分离架构,部署简单。作为统一认证平台,除了性能,稳定性,新特性之外,易用性也是考量的重要标准,Casdoor 后端使用 Golang 语言开发,前端使用 React.js 框架,使用者只需启动后端服务,并将前端工程文件打包,即可直接使用,操作简单,上手难度低。 ...

对客提供搜索功能,其中有一个过滤条件是过滤用户已转存数据。 现在问题是如果有 2000 个用户都对同一个数据进行了转存 那该怎么实现这个方案呢? 最开始我想的是在 ES 上加一个转存用户 ID 列表 但是如果 2000 个用户都正好在一个热点数据上 岂不是这个字段需要挂一个 2000 个元素的列表,好像不太好?

所以请教各位大佬 行业有什么标准方案吗 或者有推荐的思路

]]>[ { "doc_key": 'a', "startsAt": '2024 年 1 月 29 日', "status": 'a' }, { "doc_key": 'a', "startsAt": '2024 年 1 月 30 日', "status": 'b' } ] 对上面样例 需要返回 doc_key=a, status=b的记录。

通过翻文档目前我实现的

{ "aggs": { "unique_doc": { "terms": { "field": "doc_key", // 每个 doc_key 有多条记录 } }, "aggs": { "latest": { "top_hits": { "size": 1, "sort": [ { "@timestamp": { "order": "desc" } } ] } }, "pagination": { "bucket_sort": { "size": 10, "from": 0 } } } } } 问题: 没有实现最后一步状态过滤。 理想是在 top_hits 中能有个 filter 过滤status字段,然后结合bucket selector 过滤 hit count != 0 的桶。

请教各位大佬该怎么做?

elasticsearch-logger 插件向 es 写入日志,但是这个插件不支持按日期新建索引,只能是一个固定的值,比如 apisix_log;同时这个插件也会写入一个别名叫 apisix;我在网上搜索了很多资料,包括也问题 ChatGPT 4,但是都没有解决我的问题,像这种情况如何做 ilm ]]>官方文档和 google 只找到了在 elasticsearch.yml 中加入 xpack 的方案接入(失败)如下:

xpack:

security:

authc:

realms:

ldap1:

type: ldap

order: 0

url: "ldap://xxx.com:389"

bind_dn: "cn=username, ou=people, dc=example, dc=com"

bind_password: password

user_search:

base_dn: "dc=example,dc=com"

filter: "uid={0}"

unmapped_groups_as_roles: false

native1:

type: native

order: 1

由于 license 是破解的,需要 run 之后进入 kibana 上传 or 采用 curl 方式 ]]>

想问一下如何扛过搜索高峰,试过阿里云的 Elasticsearch Serverless 服务,但是有限制,每秒钟只能通过 60 个请求,多余的会被拒绝掉。有什么别的办法吗

]]>然后我看到了一个 copy_to 的功能, 就想着直接增加一个新的 field 到 index 数据库里面去,这样每次插入的时候,自动复制 _id 的值到 id 字段上,然后搜索的时候就直接用 id 对结果进行排序就好了。但是试了下不行,增加新 id 的句子如下:

PUT /my_index4 { "mappings": { "properties": { "_id": {"type": "keyword", "copy_to": "id"}, "name": {"type": "text", "copy_to": "total"}, "age": {"type": "integer"}, "type": {"type": "keyword"}, "id": {"type": "keyword", "store": true} } } } 直接报错了,说 _id 字段重复。这样的话,有什么解决办法吗?

]]>ES 写入非常慢(如上图所示),使用 k8s + nfs ,这块不是很熟悉,有偿求技术支持。

有意的老哥,可留下联系方式。

有效期:10/10 —— 10/11

]]>目前思路是通过 logstash 读 kafka 数据,拆分后进 es 中建索引,但是最终想统计的是账号所在的部门对某个站点的访问量,例如:1 个月内,技术部,访问 www.163.com 的次数。

现在索引里面只有账号信息,账号和部门的对应关系在其他数据库中,应该如何把部门信息与账号匹配后存在 es 中?

现在想到的两种方式(但是不知道是否可以以及如何实现)

1.将账号和部门信息存在文件或 redis 里,logstash 有多个 input ,同时从 kafka 和文件读,从 kafka 读一条日志的时候,用账号去匹配部门,然后一起写到 es 中,如果可以,需要用 logstash 如何来实现?

2.logstash 正常处理日志进 es ,在 es 中新增一个部门字段,然后用账号匹配部门信息(不知道如何实现),写到这个新字段里。这样应该用到 es 的什么功能?

Elasticsearch 新手,望不吝赐教。 ]]>

这样的语法是可以实现模糊搜索的,因为 content 是富文本内容。如果 content 的内容文本大小超过 ignore_above 的设定,那就不会被索引,也就是即使有关键词匹配到,文档也不会被搜索到 ,而 ignore_above 也是有大小限制,请问这种需求应该怎么处理 。感谢

]]>- 超过纪元( 1970 )以前的日期无法使用整型表示,要用日期格式的字符串

- 可又说,内部日期都会转为整型,表示 milliseconds-since-the-epoch ==》 那这种情况,若 1970 之前的日期呢?难道是区别对待吗?分两种情况存储吗?( 1 ) 1970 后的日期,不管啥格式都内部转整型存储 ( 2 ) 1970 前的时间,就用字符串存储

若有大佬知晓,还请不吝解释。

以下为官网原话:

]]>

- Values for milliseconds-since-the-epoch must be non-negative. Use a formatted date to represent dates before 1970.

- Internally, dates are converted to UTC (if the time-zone is specified) and stored as a long number representing milliseconds-since-the-epoch.

- Queries on dates are internally converted to range queries on this long representation, and the result of aggregations and stored fields is converted back to a string depending on the date format that is associated with the field.

- Dates will always be rendered as strings, even if they were initially supplied as a long in the JSON document.

还是数据做双写

索引就两个字段,id 和 content ,主要就是实现 content 的模糊搜索

现在单索引 4000 万数据,大小为 35G ,机器内存 16G

刚开始一千多万数据的时候第一次搜索 2-3 秒,后面搜索基本上 1-2 秒

两千多万的时候首次搜索 5-6 秒,后面搜索 2-3 秒

现在三千多万数据了,首次搜索达到了 10 秒,后续搜索 3 秒左右

这种情况怎么做预加载?看手册用 Eagerly load fielddata 和 Eagerly load global ordinals 都行不太通,内存分给 es 就 8G ,content 字段肯定就超过 30G 了,不可能丢到内存里面去。

还有什么办法?

]]> 我很 开胃<span style='background-color:greenyellow'>健脾</span>补元气 <span style='background-color:greenyellow'>我</span>很 开胃健脾补元气``` ```<span style='background-color:greenyellow'>我</span>很 <span style='background-color:greenyellow'>开胃</span><span style='background-color:greenyellow'>健脾</span>补元气``` 还是只能自己实现?好像找了几年都没找到。。

]]>栗子:

name age sex

张三 20 男

李四 21 男

alice 20 女

bob 22 男

张翠山 18 女

julia 19 女

要求:

让张三,李四,张翠山靠前,alice, bob, julia 靠后。 ]]>

ES 将数据写入到 Memory Buffer ,同时也会将数据写入到 Translog 。

Memory Buffer 在历经 Refresh Interval ( 1 秒) 之后会把数据写入到 File System Cache ,再由 File System Cache 写入到 Segment 。

而 数据写入到 Translog 之后,要经过 5 秒 才会持久化到磁盘 log 中。

我理解 Translog 本身应该是类似于 MySQL Binlog 一样是防止数据丢失的。

但是目前看来 5s 的时间是否过长了,我理解 5s 怎么也完成 数据 从 内存 持久化 到 Segment 了啊..

]]>图中数据源,源于 nginx 请求日志。需要对指定 url path 进行匹配,忽略 query 参数。比如需要通过 /helloworld/haveadrink 匹配以下 url:

- /helloworld/haveadrink?date=2011&price=10

- /helloworld/haveadrink?q=google

- /helloworld/haveadrink?abcdefg=wafd

请问该怎么写 query 语句?

]]>然后根据需求变更在该索引增加了字段,

但是 在 discover 这一项,一直查看不到新增的索引字段,

请问下,该如何操作,才能让该索引字段展示出来

]]>搜索请求被发送到某个节点时,这个节点就变成了协调节点,协调节点会转发请求到索引的每个主分片或副本分片中。每个分片在本地执行查询并添加结果(ID 和排序值)到大小为 from + size 。如果有 n 个节点。协调节点会收到 n*(from + size) 的结果(ID 和排序值)。

2.fetch

协调节点 接收到 n*(from + size)的结果,将其全局排序。然后取当前页的数据,向相关的分片取完整的数据。

那 scroll 完成分页,不也要经历这两步? 第二步 fetch 阶段不也是耗性能的深度分页吗?是不是说 scroll 第二部只做一次,然后将其全局的数据保存成一个快照。之后就不会取 fetch 。 但是 from ,size 是每次都要做 fetch ? ]]>

现有的方案是 :

1.接受数据变更 MQ 消息

2.去 MySql 查询业务数据组装成 JSON

3.合并更新 MongoDB 中..

4.跑批更新到 ES 中(一个比较复杂的树形结构)

现有的问题 :

1.跑批任务经常卡死,不可靠

2.业务变动,总是需要我去开发 java 代码

我寻思 ES 这块应该有工具的,所以我去查了一下 Kettle 应该符合我的要求.

设想是跑批任务定时拉去 Mysql 拉去业务表的变动,然后通过一系列的转换流程补充成完整的业务 JSON(多张数据表组装成 JSON),在更新到 es 中(省了 MongoDB 这步)

询问了下我们公司的数仓同事,他们也在用阿里云的 DataWorks 工具.我研究了下发现这个工具只能做简单的同步数据映射,达到我设想的多张表聚合成一个 JSON 貌似要使用 EMR 引擎,我对这块特别不熟悉.完全没有头绪感觉 EMR(我理解为大数据相关的工具)学习成本太高了..

总结一下想了解的问题:

1.如果有其他方案,请不吝赐教

2.麻烦帮我权衡一下使用 Kettle 还是 DataWorks(二个都不会用,不是很想学大数据相关的技术 纯门外汉)

考虑 DataWorks 的原因是我们公司喜欢上云服务,减轻运维压力 ]]>

当我用 spring data elasticsearch 的 repository saveAll 操作去批量插入 100 条数据时,发现耗时在 200 ms 左右。其实我感觉这个速度跟正常用公有云的 rds 批量插入数据是差不多了。

那么问题来了,es 这个插入速度是正常的吗,是不是还有其他优化参数可以配置,用来提升这个插入性能?如果这样是正常的,那么 es 在插入和查询上相比于 rds ,在实际应用中,优势体现在哪些地方呢?

]]>最终返回前端结构是一个父,带三子。优先匹配父 name ,然后找三个子,三子也按 name 匹配排序。如果父 name 没匹配,那就是子 name 匹配了也算。

具体场景就如 公司-员工结构,搜索的名字可能匹配公司名,或者员工名。优先匹配公司名,然后下面展示 3 个员工名。员工名也是按匹配优先度排序。

eg:

搜索 name match 张三

1. 张三有限公司(张三,王五,xx )---- 公司名含张三,员工名含张三 最优先

2. 张三无限公司( xx ,xx ,xx ) ---- 公司名含张三,员工名不含张三 次优先

3. 李四有限公司(张三,xx ,xx ) ---- 公司名不含张三,员工名含张三 最低优先

公司、员工都不含张三则不符合条件

看到个 top_hist 但里面 hits 的内容是不能 match 排序

大佬们有什么好的方法吗 ]]>

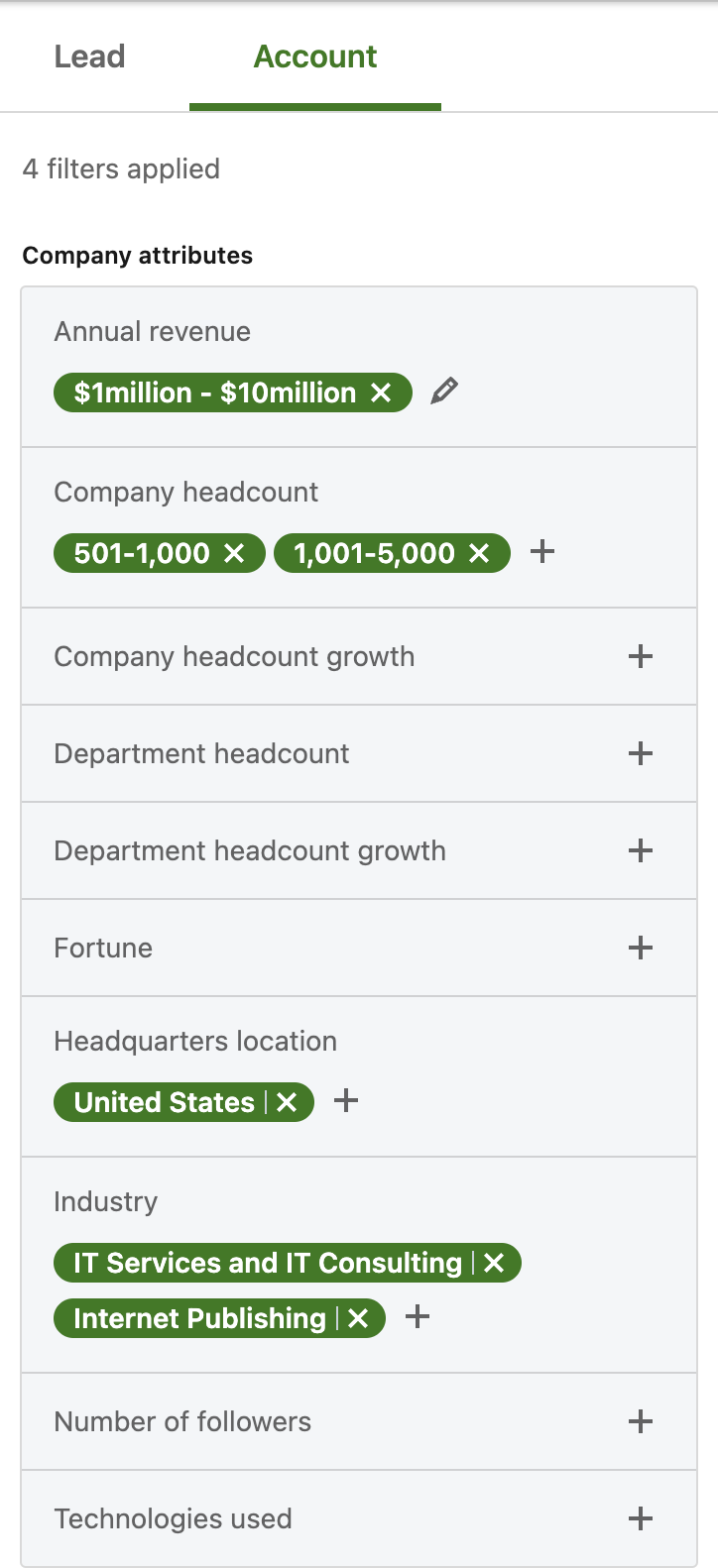

每个维度可以选择 0 个,1 个或多个条件